はじめに

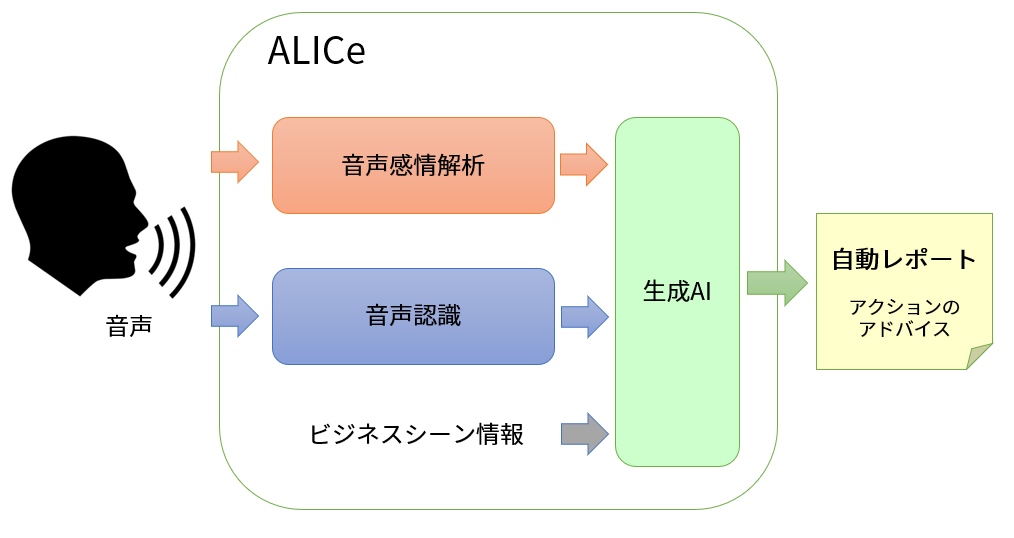

当社のプロダクトであるALICeは音声から話者の感情を数値化して可視化し、その値からビジネスシーンでどのような対応をとるべきかをアドバイスするソリューションを提供しています。

このコラムでは音声から感情はどのような仕組みでわかるのかについて解説します。

この仕組をご理解いただくためには音声そのもの特性、発声機構、聴覚機構、脳の感情認知、深層学習、機械学習、周波数分析、時系列波形分析、などに関するある程度の知識が必要なのですが、今回のコラムではこれらの知識が無い方を対象に、音声から感情がわかる仕組みのアウトラインを解説します。

もっと詳細なしくみに関しては別のコラムで述べる予定です。

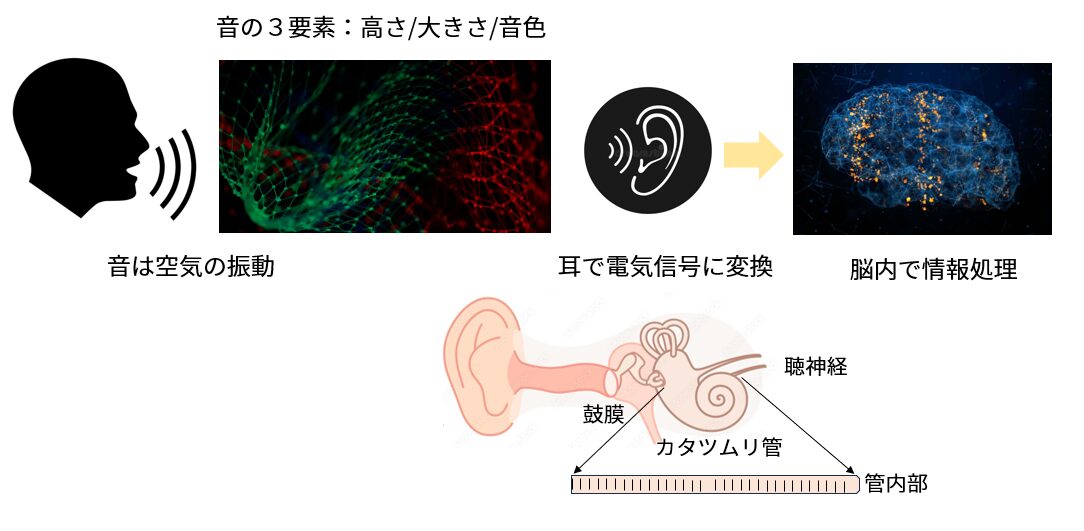

1.人間はどのように音声を聞くのか?

人間の声は脳からの信号により、声帯を震わせて周囲の空気を振動させ、声道と言われる喉や鼻腔部分で特定の振動数の空気振動を増幅や減衰させて口から出します。

これを共鳴と言います。

脳からの信号には感情が含まれており、感情により声帯の振わせ方が異なるとともに、声道の形(長さ、太さ、形状)も大きく変化させます。

楽器に例えれば、木管楽器のリードが声帯に相当し、管に付けられた複数の穴をふさぐことにより管の中の空気の通過距離を変化させてさまざまな音色を出すことに相当しますが、人間の場合は声道の形は変幻自在に変化し、様々な音色を出すことが可能です。

この音色の中にこそ感情を示す信号が含まれていて空気の微細な振動波形を生成します。

聞き手は空気の微細な振動波形を電気信号に変換し、神経を経由して脳に送られます。

空気振動→電気信号変換の役割を担うのが耳で、特に鼓膜とカタツムリ管と呼ばれる器官です。

鼓膜はマイクロホンに相当し空気振動の波形を耳骨に伝えて耳骨を振動させます。

この耳骨の振動はカタツムリ管と言われるリンパ液で満たされた細長い器官に伝えられ、リンパ液を波立たせます。

この波の振動をカタツムリ管内部の非常に細い毛が感知し、電気信号に変換します。

リンパ液の波がカタツムリ管内部の毛を刺激する位置と強さを感知することにより、波動の強さと周波数(高さ)が詳細に電気信号に変換され脳に送られます。

脳に送られた電気信号には音の大きさ(音量)、高さ(周波数)、方向の情報が含まれていてこれを脳内で処理します。

この処理のやり方は非常に複雑で脳内のさまざまな部位(聴覚皮質、記憶部位、言語処理部位、等)が関与しています。

過去に聞いたことがある音のパタンが大量に脳内に蓄積されており、そのパタンと入力された電気信号とを比べることにより音の中の声の部分を認識すると言われています。

2.音声に含まれる情報

脳で「声」と判断された音は単に書き言葉に変換できる情報(言葉の意味)を伝えるだけではありません。

声に付随した様々な付加情報を認識します。

この付加情報が感情です。

日本音響学界が刊行している「音声は何を伝えているか」という本によれば、人間の話す音声は、単に書き言葉が示すメッセージ以上の情報を含んでいます。

それは下記の3種類で、「藤崎の分類」と言われるものです。

1) 言語的情報

文字により表現が可能で、話者が意図的に生成する情報です。

音声から文字への変換ソフトの対象となる情報です。

音声認識はこの情報を使って声から文字に変換するテクノロジーです。

2) パラ言語的情報

パラ言語的とは言語周辺的と言う意味で、文字には表現できないが話し手の意志を伝える情報のことを言います。

例えば「これを下さい」という場合に丁寧に言う場合と雑に言う場合があると思います。

前者は聞き手に感謝を伝え、後者はいらいら感や怒りを伝えることが出来ます。

俳優は演技で音質を変えパラ言語情報を伝えます。

意図的感情とも言われます。

3) 非言語的情報

これは話者が意図的に制御できない感情を伝える情報です。

不随意感情とも言われます。

例えば怒りがこみ上げて来て自分の意志とは無関係に声が震えるとか、冷静に声を出そうとしてもおかしくて声が波打つようになってしまう時の情報です。

「声にならない声」という表現がありますが、感情が高まって、言葉を通常の音声として発声できない状況のことを言います。

悲しい話ですが、お子さんを事故で亡くした親御さんの話を聞いたことがあるのですが、亡くなったお子さんの話になると涙声になり声が震えたりします。

また話の途中でため息をついたり、言葉を詰まらせたり、長い間を取ることがよくあります。

また少し落ち着くと、感情を抑えながら話すために、言葉をゆっくりと選びながら話すことが多いようです。

これらは作為的にそのような声の質を作り出しているのではなく、悲しみの感情が脳を刺激し発声時の生理状態を通常とは異なる状態にするからです。

当社の提供するALICeではこの非言語的情報を数値化して出力します。

従って、話し手の真の感情をとらえる事ができ、かつ聞き手の特性によらない客観的な感情数値を得る事ができます。

これを当社では「本物の感情(Genuine Emotion)」と呼んでいます。

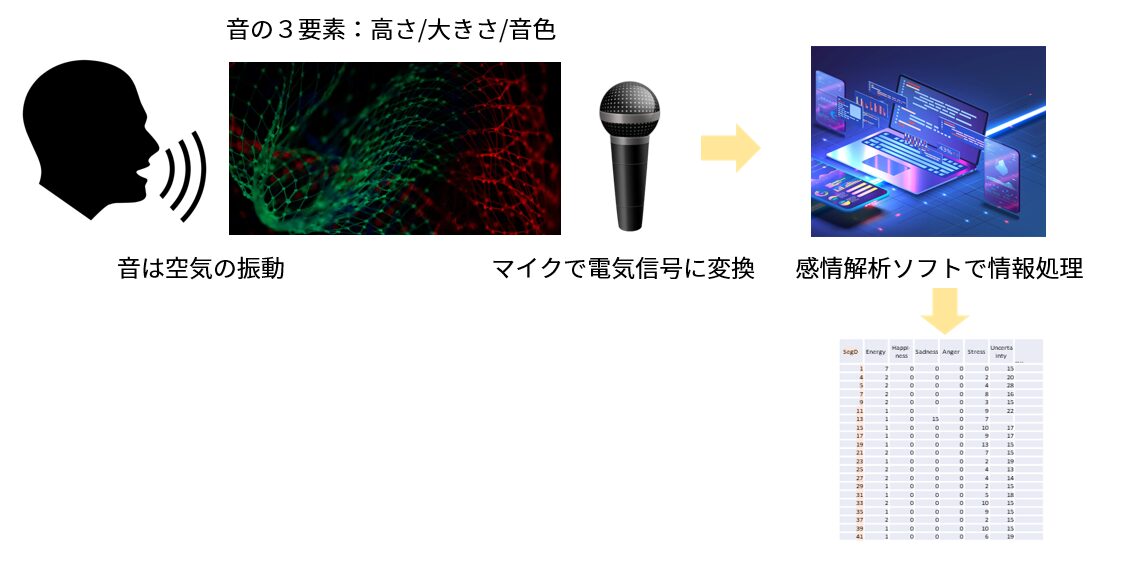

3. コンピューターによる感情認識

では、コンピューター内のソフトウエアでどのように情報処理すると感情に関する情報が取り出せるのでしょうか?

これを説明する為には音そのものと声に関する性質をもう少し詳しく理解する必要がありますが、概要は以下の図のように、耳の代わりにマイクを用いて音声を電気信号に変換し、その電気信号をコンピューターが脳の代わりに解析し、約2秒毎にその信号が声かどうかを判断し、声ならば言語情報、意図的感情情報、不随意感情情報のいずれかを認識します。

すなわち、脳で行っている情報処理の一部をコンピューターで行わせているのですが、脳の機能にはとうてい追いつけません。

脳の機能をどのようにコンピューターで代行させるのかにはいくつかの方法があり、ソフトウエア開発メーカーにより異なります。

その方法は大別すると2種類あり、言語情報をAIで分析して感情を推定する方法と使わない方法があります。

1) AIを用いる方法

IBM社のWatson Tone Analyzerサービスはこれに該当します。

声をまず音声認識技術を用いて言語化して文章作り、その文章から機械学習やディープラーニングのAIテクノロジーを用いて感情を推定する手法です。

2) AIを用いない方法

もう一つは言語情報を用いず話者の声から音の3要素である、高さ、大きさ、音色を収集したデータと照合してAIテクノロジーを使わずに、過去から収集している音響パタンと感情との対応関係データベースと照合して分析する感情推定方法で当社の提携先であるEmotionLogic社が採用している方法です。

この方法については別のコラムで少し詳しく述べる予定です。

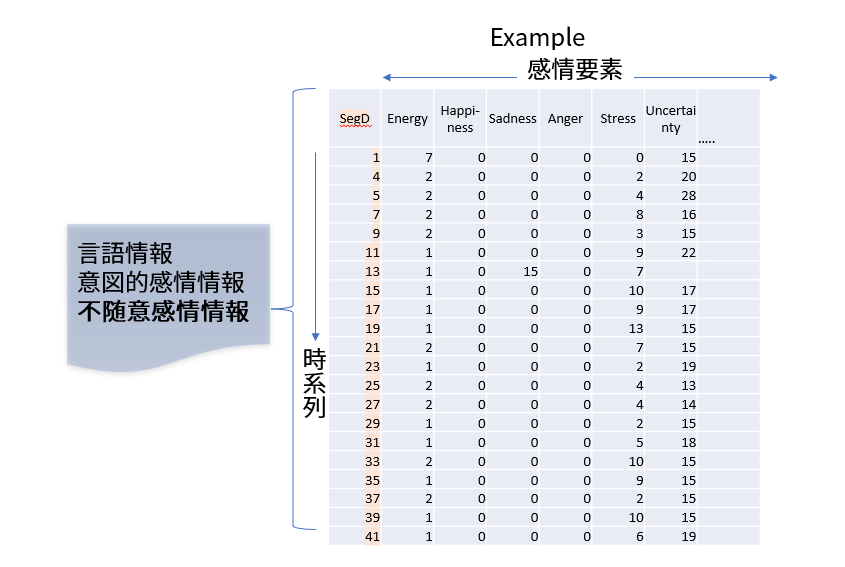

4. 感情の出力(原理)

音声から感情情報を認識したコンピューターは次にストレス、不安、怒り、喜び、自信、などの感情を数値で表現します。

この表現方法は感情解析ソフトの開発ベンダー毎に異なります。

当社では次の手法を採用しています。

人間の感情は単純なものではありません。

ストレス、不安、怒り、喜びなどさまざまな感情が同時に沸き上がります。

嬉しいけど憎い、怖いけど嬉しいなど一見矛盾した感情も同時に脳内に存在します。

従って、単純に人間の感情状態を「怒り」、「喜び」、「ストレス」など単一の状態で表現することは出来ません。

そこで当社のALICeでは提携元のEmotionLogic社の感情表現方法に従って感情要素という概念を採用しています。

これは人間の感情状態を、感情エネルギーの程度、喜びの程度、悲しみの程度、怒りの程度、など感情要素に分解し、その人が抱いている感情要素の程度を数値で表す方法です。

感情状態は時系列的に変化しますから、図に示すように、約2秒毎の感情要素の値を列に時刻(2秒毎)を、感情要素を行にした行列形式で出力します。

感情の種類は数十あり、使用目的により異なります。

これに関しては別のコラムで詳しく述べるつもりです。

5. ビジネスシーンでのアクションプランのアドバイス

上記で述べた感情要素出力は、コールセンター、採用、メンタルヘルス、Webミーティング、不正申告、捜査支援など、様々なビジネスシーンで使われます。

他社の感情解析ソフトですと感情出力を提示はするのですが、それをどのように使うのかはユーザーに任されることが多いようです。

研究者のように経験深いエンジニアを抱えるユーザーなら自ら感情出力をビジネスシーンで適応するかを自社で研究開発できますが、多くのユーザーは感情出力を提示されただけではどのように適応するかはわかりません。

そこで当社は、ビジネスシーンに応じてどのようにアクションすべきかを自動レポートする機能を準備しています。

これは音声認識機能の出力と音声感情解析ソフトの出力を、ビジネスシーン情報とともにChatGPTやGeminiなどの生成AIに入力することにより行います。

これによりユーザーはどのようなアクションを取るべきなのかが容易にわかるようになります。

この詳細も別途コラムにて述べる予定にしています。

おわりに

今回は音声による感情解析の全体像を知っていただくために、細部にこだわらずに全体の流れのアウトラインをご紹介しました。

次回以降のコラムでは少し詳細に解析テクノロジーをご紹介するつもりです。

ご期待下さい。